『Alan Wake 2』におけるマインドの内側(連載)

「『Alan Wake 2』におけるマインドの内側」では、このゲームのオーディオエクスペリエンスを形成したクリエイティブな過程と技術的なプロセスを深堀りします。『Alan Wake 2』のサウンドスケープの裏にある決断、課題、そして革新に迫る連載です。ゲームの世界観に息を吹き込んだオーディオチームのマインドの内側を覗き、動的なダイアログや没入感あふれるエコーのつくり方、オーディオQAの重要性、そして本ゲーム独自のプロファイリングシステムを紹介します。

第1回目では『Alan Wake 2』のダイアログ実装の詳細をシニア・ダイアログ・デザイナーのアーサー・ティセロンとタネリ・スオランタが、話し言葉とナレーションを組み合わせたダイアログの相互関係について解説しました。まだご覧になっていない方は、『Alan Wake 2』おけるマインドの内側:ダイアログの区分けをお読みください。

第2回目はプリンシパル・オーディオデザイナーのTazio SchiesariがWwiseを使用して、エコーインタラクションのサウンドデザインに取り組んだ舞台裏を紹介します。進化するインタラクティブなサウンドスケープを形成する上で、グラニュラー合成技術がどのように役立ったのかが明らかになります。

はじめに:Wwiseを使用したエコーデザイン

エコーは『Alan Wake 2』に導入されているゲームプレイのメカニズムであり、ウェイクが執筆する小説の主人公であるアレックス・ケイシーが巻き込まれる並行世界の物語のビジョンです。それらのビジョンは、ウェイクが13年間囚われていた悪夢の次元である「闇の世界」から脱出する方法を執筆するための、インスピレーションの源となります。

エコーを詳しく解説

エコーは実用的な観点から2つのメインコンポーネントに分けることができます。

- エコーインタラクションは各レベルに配置されるエンティティです。かすかな光を発するVFXで視覚的に表現され、プレイヤーによるインタラクションが必要です。このインタラクションはパズルのメカニズムになっており、プレイヤーは正しい視野角を見つけてビジョン部分に近づき、ストーリーをすすめる必要があります。

- エコービジョン自体は、ゲームの3D環境にシネマティックにオーバーレイされるライブアクションです。

このブログ記事では、エコーインタラクション部分に焦点を当てます。そのため、エコーインタラクションをシンプルに「エコー」と呼び、オーバーレイされたシネマティックを「ビジョン」と呼びます。

課題:サウンドデザインにダイアログを組み込む

ゲームディレクターのKyle RowleyとSam Lakeがエコーのサウンドデザインに取り組んだ際に最初に手掛けたのは、逃げ出すことができない囚われたボイスサウンドを制作することでした。

ゲームのサウンドデザインにダイアログを組み込むことは、諸刃の剣となることがよくあります。ダイアログは強力なストーリーテリングツールになる一方で、特にローカライズを検討する際に大きな課題が生じます。台詞を多言語に翻訳することで、作業量が大幅に増える可能性があります。またこの追加の作業は従来的に、多忙を極める制作の最終段階で発生します。

エコーのサウンドアイデンティティの構築

最初にエコーのプレースホルダとして、それと気づかないほど巧みに処理したボイスループを試しました。しかし、この方法では繋がりが不自然に感じられました。ビジョン内のライブアクションで再生される台詞との違いに非常に違和感を覚えたのです。私はこうした懸念事項を一旦棚上げし、本当に実行したかったアイデアを探求することにしました。

エコーのサウンドデザインがビジョンのダイアログとよりマッチするように、実際のライブアクションシーンの最初の2、3語を使用することにしました。このアイデアはプレイヤーがエコーメカニズムの解決から遠ざかった時に、ビジョンから逆方向に作用させ、はっきりした台詞をレンダリングして途切れ途切れの曖昧な台詞にするためのものでした。反対にプレイヤーが解決に近づくと、台詞をよりクリアで明瞭にしました。

この不明瞭なループボイスはエコーの場所を見つけるための手がかりへとプレイヤーを導く役目も果たしました。ほかにも「闇の世界」のおぼろげで不安定なサウンドスケープに自然に溶け込んで、ゲームオーディオの方向性にテーマを合せる一方で、不気味な雰囲気も加えました。

グラニュラー合成技術でデザインを実現

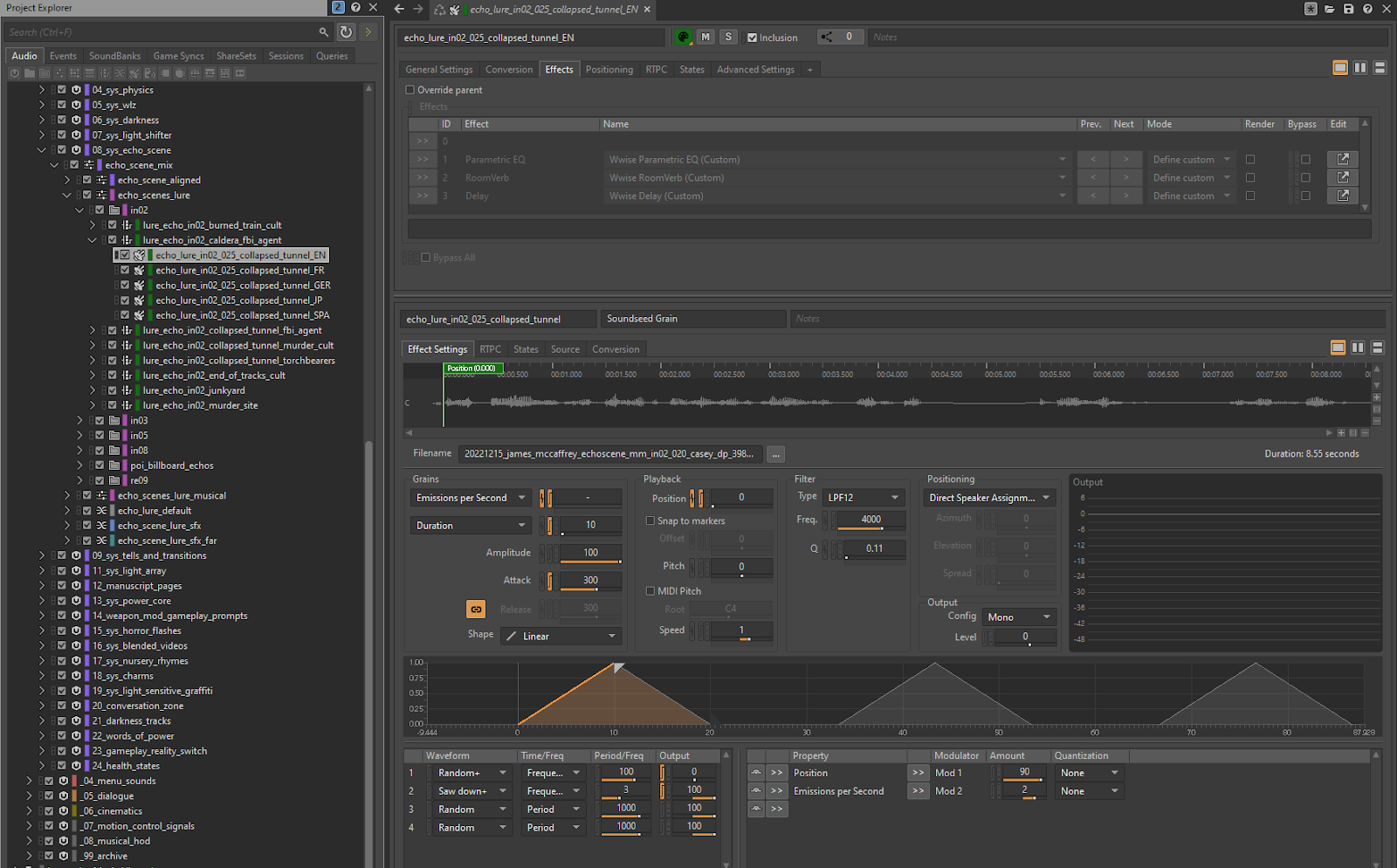

ゲーム内でこのサウンドデザインを実現するためにたどり着いたのが、WwiseのSoundSeed Grainです。

グラニュラー合成技術を確実に理解し、非常に簡単にコンセプトを実行に移すことができました。

ダイアログのオーディオファイルをインポートした後、最初に目指したのは、グラニュラー再生を通してオリジナルの台詞に可能な限り近づけることでした。これはプレイヤーがエコーの解決間近になった時にトランジションポイントの役目を果たし、2つの異なる再生方法(エコーインタラクションではグラニュラー、ビジョンではリニア)の違いを曖昧にしました。

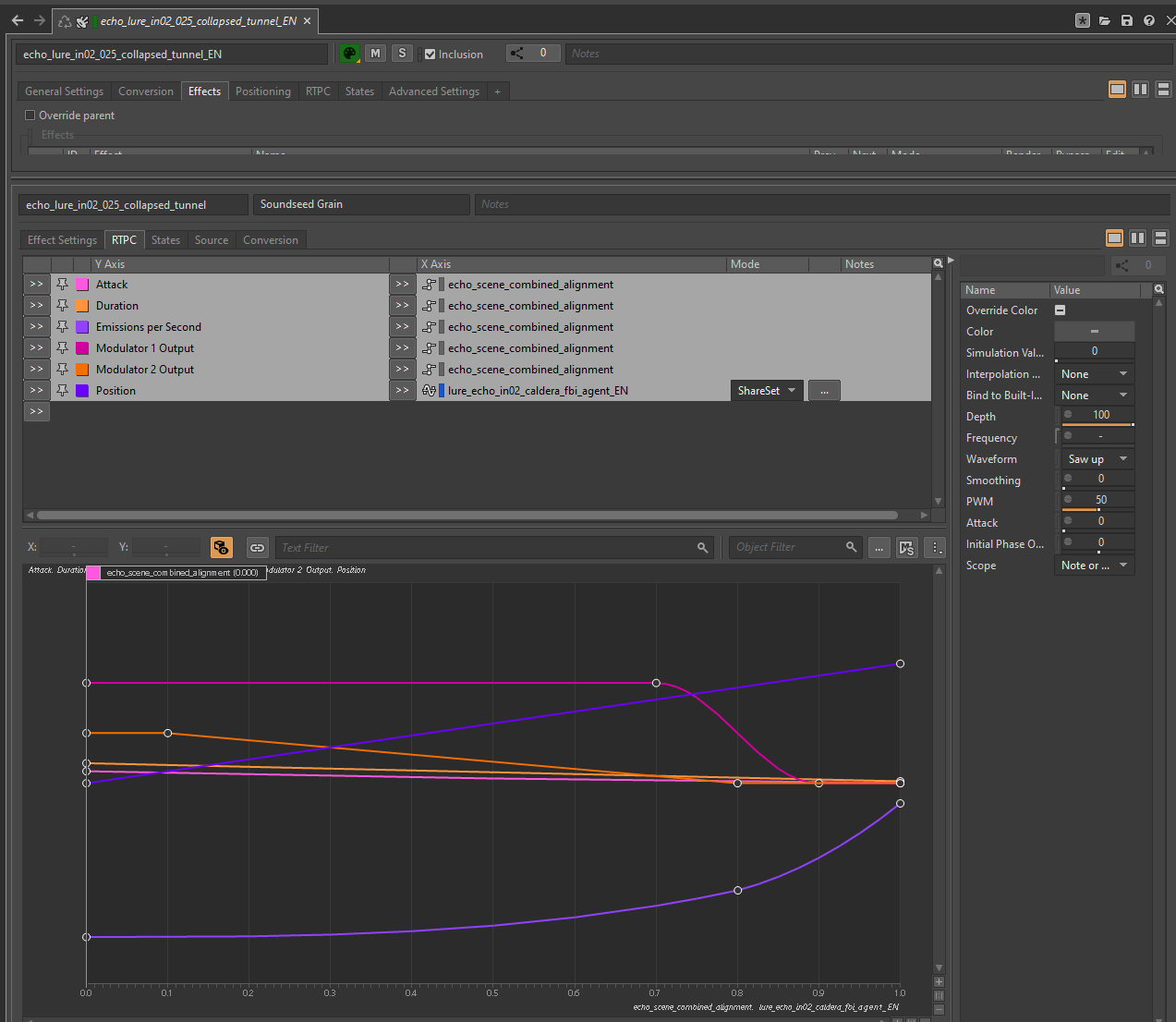

これを実現するために、ランプモジュレータを使用して位置をスクラブし、オリジナルの台詞と一致させるためのランプの最適なモジュレーション速度や、話し言葉に最も合うグレイン設定を探しました。

そこからアタックタイムを長くして広く分散させたグレインを使用して、フレーズを解体することを試みました。再生位置をランダム化して再生方向をノンリニアに変えたことで、ランダムな単語や音節が無作為に発せられるようになりました。これによりサウンドのリズムが乱れ、一貫性がなくなりました。

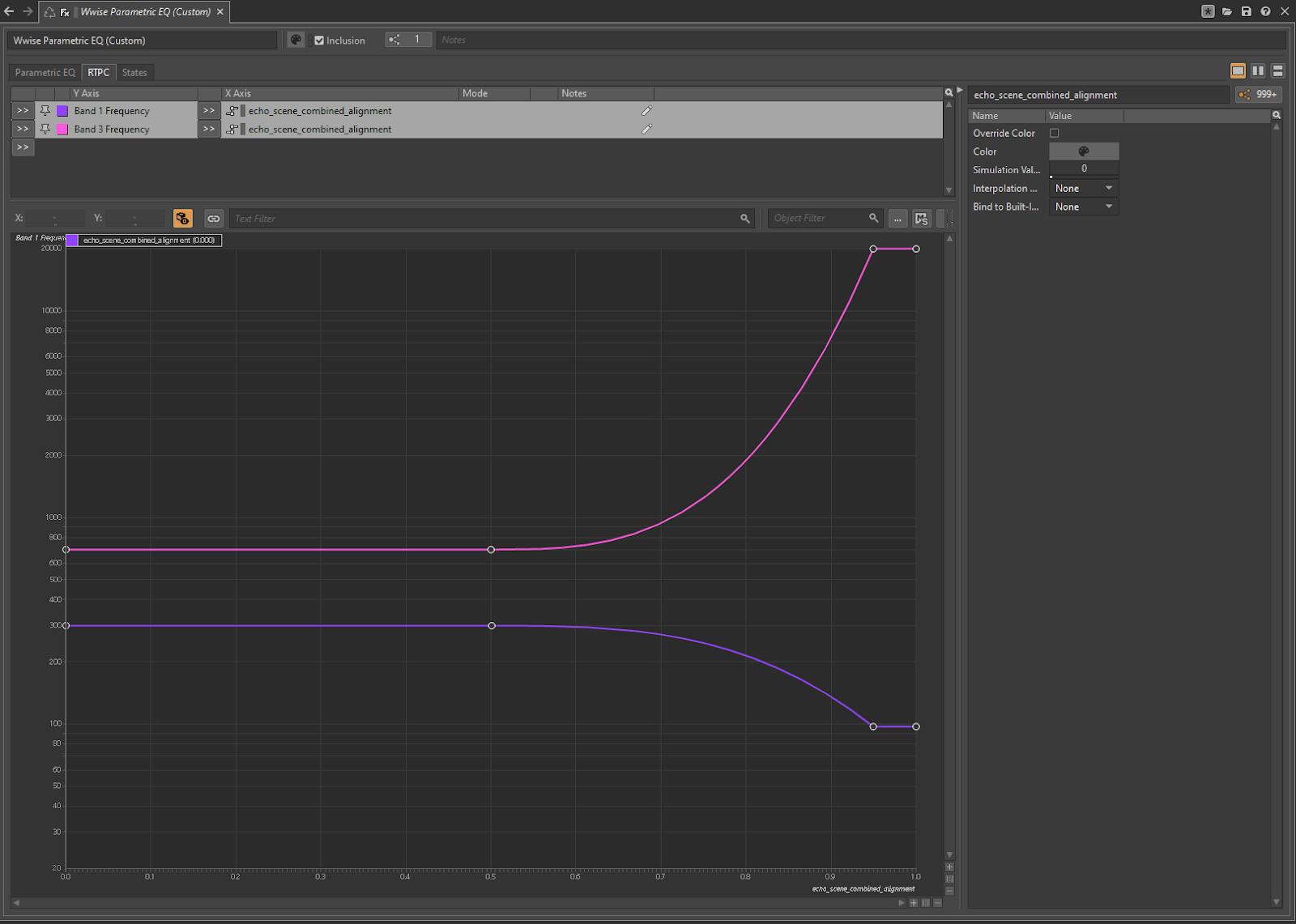

最後に3つのリアルタイムエフェクトを最上位の親であるディレイとリバーブに適用して、ダイアログをミックス内でさらに後方にプッシュし、距離や3バンドEQに応じて明瞭度を下げました。3バンドEQはハイパスフィルタとローパスフィルタを組み合わせる機能があり、ボイスの周波数の範囲を500 Hzほどに絞って、バブルに囚われた感覚のボイスを作り出しました。プレイヤーがエコーの解決に近づくと、これら3つのエフェクトが次第に弱まっていきます。

その結果、ゲームの雰囲気と目的の両方に合った、インタラクティブで進化するサウンドスケープが完成しました。

ローカライズの課題を克服

この課題についてですが、ローカライズによって作業量が増えると思われていましたが、1日余分に必要になっただけでした。適切な計画と気が利くMAXパッチのおかげです。このパッチはエコーごとに各言語固有のパフォーマンス位置をスクラブするための、適切なモジュラー設定を把握するために私が作成したものです(合計170個の独自のモジュラーです)。

次のビデオで画面の右下にあるグラフは、カメラの向きとエコーからプレイヤーまでの距離を組み合わせたRTPCを示しており、解決までのエコーインタラクションの距離に基づいて変化します。RTPCと共に動的に変化するJames McCaffreyの、ゆっくりとしたテンポの象徴的なボイスを注意深くお聞きください。

これを達成するためにオーディオの技術的な側面から多大なるご支援をいただいた、Josh Adam BellとKit Challis(シニア・テクニカルオーディオデザイナー)にも感謝の意を表したいと思います。

一部のプレイヤーは気づいたかもしれませんが、Remedyらしいエコービジョンの最終段階では、キャラクターのシルエットがオーディオに合わせて動きます。これはVFXが台詞から送られるオーディオデータに反応していることを意味します。それについては、また別の機会に説明します。

コメント